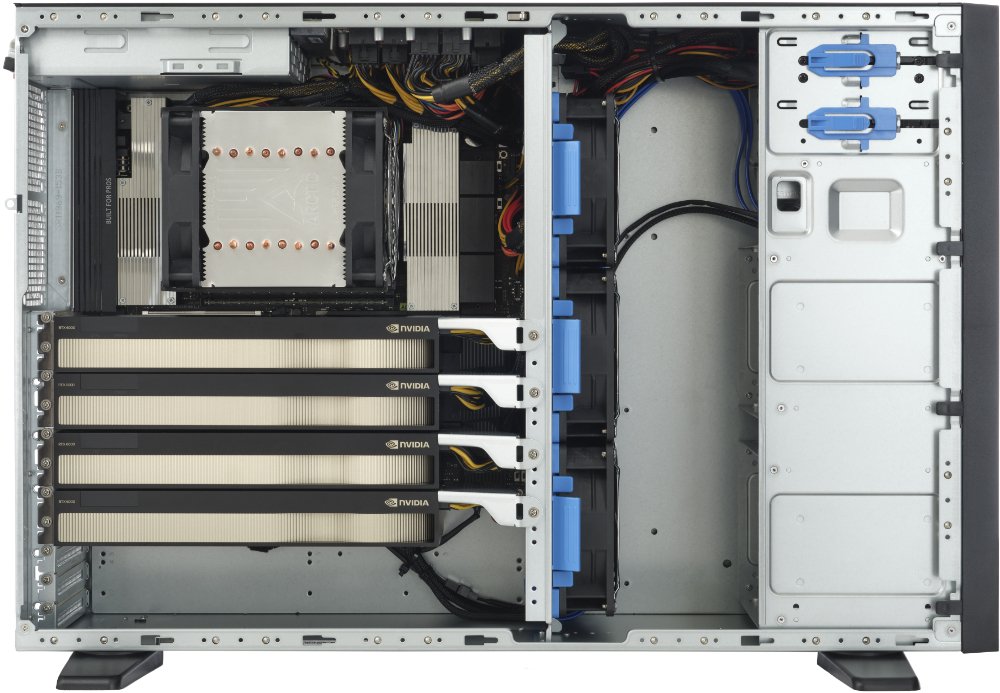

AIME G500 - Deep Learning Workstation

Die AIME G500 ist als wartungsfreundliche High-End-Workstation mit ausreichend Kühl- und Netzteilkapazität konzipiert, um bis zu vier High-End-GPUs zu betreiben. Es handelt sich um die AIME-Workstation der 5. Generation, basierend auf der der neusten AMD Threadripper CPU-Generation mit Unterstützung für DDR5-Speicher und PCIe-5.0-Bus-Technologie.

Leistungsstarke temperaturgesteuerte Lüfter kühlen die GPUs und die CPU auf optimale Betriebstemperatur. Die heiße Luft wird auf direktem Wege aus dem Gehäuse heraus geleitet und verhindert so einen Hitzestau im Inneren des Gehäuses. Das Lüftungsdesign ermöglicht die optimale Kühlung des GPU-Arrays und damit einen 24/7-Betrieb unter Volllast bei höchster Leistung.

Definierbare GPU-Konfiguration

Wählen Sie die gewünschte Konfiguration unter den leistungsstärksten NVIDIA-GPUs für Deep Learning und Rendering:

Bis zu 2x NVIDIA RTX 4090 24GB

Die Geforce RTX™ 4090 ist das Flaggschiff der NVIDIA Geforce Ada Lovelace GPU-Generation. Sie ist der direkte Nachfolger der RTX 3090. Die RTX 4090 kombiniert 512 Tensor-Kerne der vierten Generation und 16.384 CUDA®-Kerne mit 24 GB Grafikspeicher für beispiellose Rendering-, KI-, Grafik- und Rechenleistung. Aufgrund der Triple-Level-Lüfterarchitektur ist der Geräuschpegel der RTX 4090 wahrscheinlich die am besten geeignete Lösung, um solch leistungsstarke GPUs in einer Büroumgebung zu betreiben.

Bis zu 4x NVIDIA RTX 6000 Ada 48GB

Die RTX™ 6000 Ada basiert auf der neuesten NVIDIA-GPU-Architektur: Ada Lovelace. Sie ist der direkte Nachfolger der RTX A6000 und der Quadro RTX 6000. Die RTX 6000 Ada kombiniert 568 Tensor-Kerne der vierten Generation und 18.176 next-gen CUDA®-Kerne mit 48 GB Grafikspeicher für beispiellose Leistung für Rendering, Grafik und KI.

Bis zu 4x NVIDIA RTX 5000 Ada 32GB

Die RTX ™ 5000 Ada basiert auf der neuesten NVIDIA GPU-Architektur: Ada Lovelace. Sie ist die direkte Nachfolgerin der RTX A5500. Die RTX 5000 Ada kombiniert 400 Tensor Cores der vierten Generation und 12.800 CUDA® Kerne der nächsten Generation mit 32 GB Grafikspeicher für eine überzeugende Rendering-, KI-, Grafik- und Rechenleistung.

Bis zu 4x NVIDIA RTX 4500 Ada 24GB

The RTX ™ 4500 Ada is built on the latest NVIDIA GPU architecture: Ada Lovelace. It is the direct successor of the RTX A5000/RTX 3090. The RTX 4500 Ada combines 192 fourth-generation Tensor Cores, and 6.144 next-gen CUDA® cores with 24GB of GDDR6 graphics memory for a convincing rendering, AI inference, graphics, and compute performance.

Bis zu 4x NVIDIA RTX A6000 48GB

Die NVIDIA RTX A6000 ist das Ampere-basierte Nachfolgemodell der NVIDIA Quadro Reihe. Sie verfügt über den selben GPU-Prozessor (GA-102) wie die RTX 3090, allerdings sind alle Kerne des GA-102 Prozessors aktiviert. Mit Ihren 10752 CUDA und 336 Tensor-Kernen der 3. Generation übertrifft sie die RTX 3090. Ausgestattet mit 48 GB GDDR6 ECC, die doppelten Menge an GPU-Speicher, im Vergleich zum Vorgänger der Quadro RTX 6000 und der RTX 3090. Die NVIDIA RTX A6000 ist derzeit zweitschnellste erhältliche NVIDIA-GPU, die nur von der NVIDIA A100 übertroffen wird. Sie eignet sich bestens für speicherintensive Anwendungen.

Bis zu 4x NVIDIA RTX A5000 24GB

Die NVIDIA RTX A5000 ist mit Ihren 8,192 CUDA und 256 Tensor-Kernen der 3. Generation weniger leistungsfähig als eine RTX 3090. Allerdings ist sie mit Ihrer 230 Watt Stromverbrauch und 24 GB Speicher eine sehr effiziente Beschleunigerkarte, insbesondere für Inferenz-Aufgaben noch immer eine sehr interessante Option.

Alle angeboten NVIDIA GPUs unterstützen NVIDIAs CUDA-X AI SDK inkl. cuDNN und TensorRT und werden damit von allen gängigen Deep-Learning-Frameworks unterstützt.

Threadripping Pro CPU-Leistung

Die für Workstations und Server konzipierte High-End AMD Threadripper Pro 7000 CPU Serie liefert bis zu 96 Kerne mit insgesamt 192 Threads pro CPU zu einem unschlagbaren Preis-Leistungs-Verhältnis mit Unterstützung für DDR5 Speicher und PCIe 5.0 Technologie.

Die verfügbaren 128 PCIe 5.0 Lanes der AMD Threadripper Pro CPU ermöglichen höchste Verbindungs- und Datenübertragungsraten zwischen allen GPUs und der CPU.

Eine große Anzahl verfügbarer CPU-Kerne kann die Leistung immens verbessern, wenn die CPU für Aufgaben wie das Aneignen und Liefern von Daten verwendet wird, um die GPUs optimal mit Arbeitslasten zu versorgen.

Mehr als 40 TB Hochgeschwindigkeits-SSD-Speicher möglich

Beim Deep Learning müssen hohe Datenmengen verarbeitet und gespeichert werden. Ein hoher Datendurchsatz und schnelle Zugriffszeiten auf die Daten sind daher für schnelle Turnaround-Zeiten unerlässlich.

Der AIME G500 kann mit bis zu zwei 8 TB Onboard M.2 PCIe-5.0 NVMe-SSDs und zusätzlich in den Front-Bays zwei U.2 NVMe-SSDs mit jeweils bis zu 15,36 TB konfiguriert werden. Insgesamt ist mehr als 40 TB hochgeschwindiger SSD-Storage möglich.

Alle SSDs sind direkt über PCIe-Lanes mit dem Prozessor und dem Hauptspeicher verbunden und bieten Lese-Geschwindigkeiten von bis zu 6000 MB/s und Schreib-Geschwindigkeiten von bis zu 5000 MB/s.

Eine Workstation, geeignet für Büro und Serverraum

Der AIME G400 wurde als bürotauglicher PC-Arbeitsplatz mit Server-Hardware konzipiert. Für den Einsatz in einer Büroumgebung empfehlen wir, die Konfiguration auf maximal zwei GPUs zu beschränken.

Bei Aufstellung in einem belüfteten dedizierten Serverraum ist der Einsatz von bis zu vier GPUs uneingeschränkt möglich. Der G500 unterstützt IPMI LAN und einen BMC (Board Management Controller) zur Fernsteuerung und Überwachung der Hardware, was für professionelle Server-Setups unerlässlich ist.

Ausgewogene Komponenten

Alle unsere Komponenten wurden aufgrund ihrer Energieeffizienz, Langlebigkeit, Kompatibilität und hohen Leistung ausgewählt. Sie sind perfekt aufeinander ausbalanciert, sodass es zu keinen Leistungsengpässen kommt. Wir optimieren unsere Hardware im Hinblick auf Kosten pro Leistung, ohne Kompromisse bei Ausdauer und Zuverlässigkeit einzugehen.

Getestet mit realen Deep-Learning-Anwendungen

Der AIME G500 wurde nach unseren eigenen strengen Deep-Learning-Anwendungsanforderungen konzipiert und aufgrund jahrelanger Erfahrung mit Deep-Learning-Frameworks und dem Bau von kundenspezifischer PC-Hardware optimiert.

AIME-Workstations und -Server werden mit vorinstalliertem Linux-Betriebssystem geliefert, vorkonfiguriert mit den neuesten Treibern und Frameworks wie Tensorflow und PyTorch. Einfach auspacken, einloggen und sofort mit Ihrem bevorzugten Deep Learning Framework loslegen.

AIME G500 Technische Daten

| Typ | Tower Workstation |

| CPU Optionen |

Threadripper Pro 7000WX Series 7955WX (16 cores, 4.5 GHz - 5.3 GHz) oder 7965WX (24 cores, 4.2 GHz - 5.3 GHz) oder 7975WX (32 cores, 4.0 GHz - 5.3 GHz) oder 7985WX (64 cores, 3.2 GHz - 5.1 GHz) oder 7995WX (96 cores, 2.5 GHz - 5.1 GHz) |

| RAM | 64 to 1024 GB DDR5 5600 MHz ECC |

| GPU Optionen |

2x NVIDIA RTX 4090 24 GB Tripple Fan oder bis zu 4x NVIDIA RTX 4500 Ada 24 GB oder bis zu 4x NVIDIA RTX A5000 24 GB oder bis zu 4x NVIDIA RTX 5000 Ada 32 GB oder bis zu 4x NVIDIA RTX A6000 48 GB oder bis zu 4x NVIDIA RTX 6000 Ada 48 GB |

| Kühlung | CPU und GPU High Air Flow Kühlung 3 Hochleistungslüfter (6000 RPM) > 100000h MTBF |

| Storage |

Onboard bis zu 2x 8TB M.2 NVMe SSD PCIe 4.0 7000 MB/s lesen, 5000 MB/s schreiben oder bis zu 2x 4TB M.2 NVMe SSD PCIe 5.0 14.800 MB/s lesen, 13.400 MB/s schreiben Front Schächte bis zu 2x 15.36 TB U.2 NVMe SSD PCIe 4.0 6800 MB/s lesen, 4000 MB/s schreiben |

| Netzwerk |

2 x 10 GBit LAN RJ56 (Intel X550) 1 x 1 x GbE LAN RJ45 1 x IPMI LAN RJ 45 |

| Audio |

Realtek ALC4080 7.1 Surround Sound HD 3 ports Audio Jack (Audio in/Audio out/Mic) |

| USB |

Front 2 x USB 3.0 Type-A Rückseite 1 x USB 3.2 Gen 2 Type-C 1 x USB 3.2 Gen 2 Type-A 4 x USB 3.2 Type-A |

| Netzteile |

2 x 2400 Watt redundant PSUs 80 PLUS Titanium zertifiziert (96% Effizienz) |

| Geräusch-Pegel | Idle < 50dBA, Full Load < 70 dBA |

| Betriebsumgebung | Betriebs-Temperatur: 10℃ ~ 30℃ Nicht-Betriebs-Temperatur: -30℃ ~ 60℃ |

| Abmessungen (BxHxT) | 175 x 438 x 680 mm |